Letzte Aktualisierung am 31. August 2023

˅ Inhaltsverzeichnis

These

Betriebssysteme können die Struktur natürlicher Sprache lernen und in eine artifizielle Sprache transformieren, mit der sie sich an künstlicher Kommunikation in soziotechnischen Netzwerken beteiligen können.

Beobachtungen

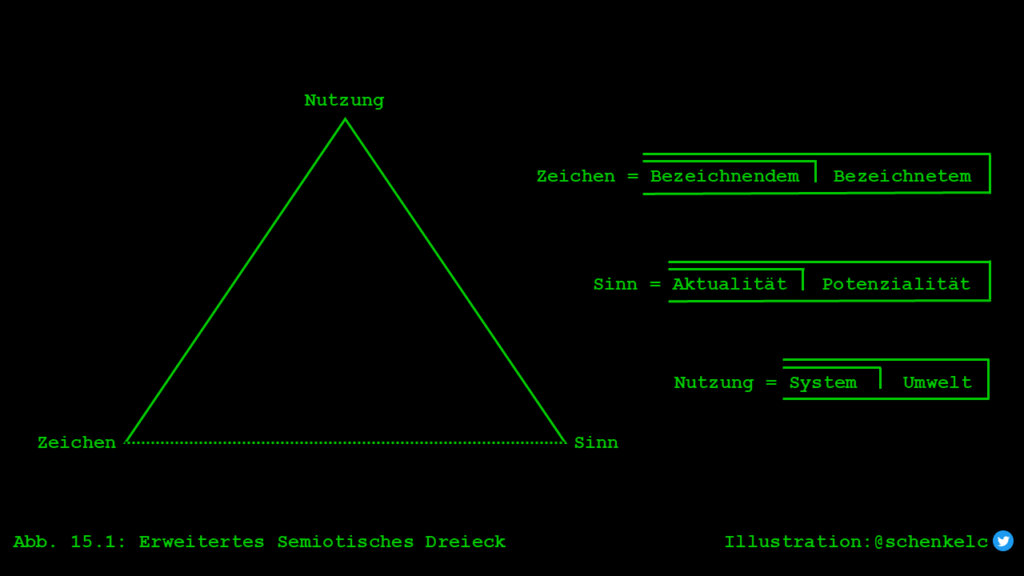

Niklas Luhmann hat seine Auseinandersetzung mit der Zeichentheorie im Rahmen der beiden Traditionslinien der Differenztheorie und des Pragmatismus geführt. Für diese beiden Traditionen stehen die Namen Ferdinand de Saussure und Charles Sanders Peirce. In Abgrenzung zu Saussure und Peirce und im Anschluss an George Spencer-Brown hat er das Zeichen einer Formanalyse unterzogen und damit versucht, eine dritte Position zu formulieren, die mit seiner Systemtheorie in Einklang steht.

˅ Zeichentheorie nach Saussure

Saussure hat zu Lebzeiten kein Buch veröffentlicht. Es gibt allerdings Mitschriften seiner Vorlesungen, die später von seinen Schülern Charles Bally und Albert Sechehaye unter dem Titel «Cours de linguistique général» mit «massiven editorischen Eingriffen» veröffentlicht wurden (vgl. Zeige 2011: 113). Ihre Interpretation der Zeichenlehre von Saussure widerspricht teilweise den später aus seinem Nachlass publizierten Texten in «Wissenschaft der Sprache».

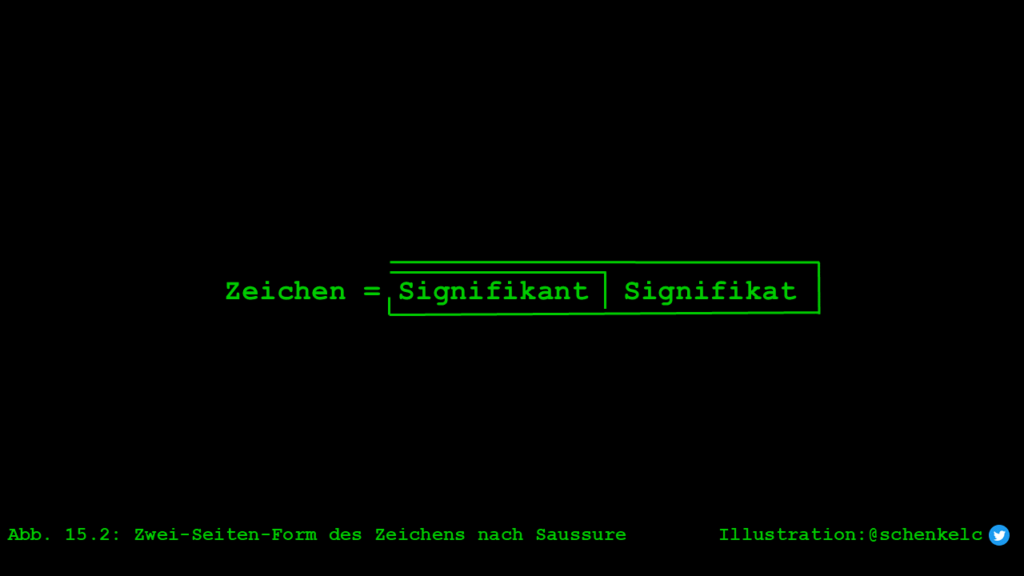

Saussure vertritt eine differenztheoretische Theoriearchitektur, die ihn zu einer dyadischen Struktur seiner Zeichenlehre führt. Ihr gemäss besteht die Einheit die Differenz eines Zeichens aus zwei Seiten (vgl. Saussure 1971: 99). Er bezeichnet die beiden Seiten mit Signifikant («signifié») und Signifikat («signifant»). Die Seite des Signifikanten steht für eine Lautbild («image acoustique»), das sich auf der Fähigkeit biologischer Systeme bezieht, mit ihrem Sprechapparat Lautbilder zu erzeugen. Es ist der äussere Ausdruck eines Zeichens. Die Seite des Signifikaten steht für eine Vorstellung («concept»), das auf der Fähigkeit psychischer Systeme beruht, mit ihrem Bewusstsein mentale Konzepte zu bilden und zu prozessieren. Es steht für den inneren Bedeutungsaspekt eines Zeichens.

Die beiden Seiten eines Zeichens sind jedoch nicht in biologisch-psychischen Operationen zu verankern. Zeichen sind nach Saussure Elemente eines Sprachsystems («langue»). Sowohl die Lautbilder als auch die Vorstellungen beziehen sich auf abstrakte mentale Konzepte. Saussure gilt daher als Vertreter einer mentalistischen Position angesehen.

Da die Einheit der Differenz eines Zeichens in der Verbindung von Signifikant und Signifikat besteht, müssen immer beide Seiten gleichzeitig aktualisiert werden, damit von einem Zeichen die Rede sein kann. Saussure veranschaulicht diesen Sachverhalt mit der Metapher eines Blattes Papier: «La langue est encore comparable à une feuille de papier: la pensée est le recto et le son le verso; on ne peut découper le recto sans découper en même temps le verso; de même dans la langue, on ne saurait isoler ni le son de la pensée, ni la pensée du son; on n’y arriverait que par une abstraction dont le résultat serait de faire de la psychologie pure ou de la phonologie pure» (1971: 157). Wir werden bei Luhmann sehen, dass die synchrone Aktualisierung beider Seiten eine Herausforderung für die Formanalyse, die mit asynchronen Formen arbeitet, darstellt.

Sussure ergänzt die Metapher eines Blatter Papier mit der Bemerkung: «La linguistique travaille donc sur le terrain limitrophe où les éléments des deux ordres se combinent; cette combinaison produit une forme, non une substance» (ebd.). Interessant ist in diesem Zusammenhang, dass den beiden Herausgebern des «Cours de linguistique général» nachgesagt wird, sie hätten den viel zitierten Satz, Sprache sei «eine Form, keine Substanz», nachträglich hinzugefügt. Es ist jedenfalls umstritten, ob dieser Satz von Saussure selbst stammt oder ob er nur der Veranschaulichung seiner Zeichentheorie dienen soll.

Die Unterscheidung von Form und Substanz soll jedenfalls verdeutlichen, dass bei der Zeichenbildung keine Verbindungen zwischen präexistenten Entitäten hergestellt wird. Vielmehr werden Signifikant und Signifikat erst in der Zeichenbildung aus zwei unbestimmten Kontinua geschaffen.

Das eine Kontinua, Lautlichkeit, besteht aus einem plastischen Material: «La substance phonique n’est pas plus fixe ni plus rigide […]» (1971: 156). Und das andere, das Denken, besteht aus einer amorphen Masse: «Psychologiquement [..]notre pensée n’est qu’une masse amorphe et indistincte» (ebd.). Die Analogie zum Konzept von Medium und Form liegt auf der Hand.

Die Zeichenbildung segmentiert beide Kontinua zugleich. Aus dem plastischen Material der Lautlichkeit wird ein abgegrenzter Signifikant und aus der amorphen Masse des Denkens ein definites Signifikat bestimmt. Dergestalt werden beide Seiten des Zeichens und das Zeichen selbst in einem Akt der Artikulation aktualisiert bzw. bestimmt.

˅ Large Language Models (LLMs)

Large Language Models (LLMs) sind computergestützte Sprachmodelle zur Verarbeitung natürlicher Sprache. Sie basieren auf künstlichen neuronalen Netzen (KNN), die mit grossen Datenmengen trainiert wurden und daher in der Lage sind, komplexe Sprachmuster sowie Beziehungen zwischen Wörtern und Sätzen zu erkennen. LLMs können Fragen beantworten, Texte generieren, übersetzen, zusammenfassen, bewerten und vieles mehr.

LLMs haben seit der zweiten Hälfte der 2010er-Jahre zusehends an Bedeutung gewonnen. Drei Entwicklungen sind dafür verantwortlich: Fortschritt bei der Entwicklung künstlicher neuronaler Netze, Steigerung der Rechenleistung von Computern und Verfügbarkeit grosser Mengen von Daten.

Verschiedene Sprachmodelle basieren auf unterschiedlichen Architekturen künstlicher neuronaler Netze. Die derzeit dominierende Architektur ist der Transformer.

Im Folgenden werden die zentralen Komponenten eines Sprachmodells mit dem Fokus auf den Transformer grob skizziert. Jede Komponente kann als eine unabhängige Funktion betrachtet werden, die aus einem Input einen Output erzeugt, der an die nächste Komponente weitergegeben wird.

Interface

Die Funktion des Interfaces besteht darin, die Interaktion zwischen Nutzer und Sprachmodell zu ermöglichen.

Eine zentrale Rolle spielt dabei der sogenannte Prompt. Er ist die Aufforderung an den Nutzer, eine Eingabe zu tätigen. Die Eingabe kann verschiedene Formen annehmen. Sie kann eine offen formulierte Anweisung oder ein konkreter Befehl sein. Der Prompt dient dem Sprachmodell als Ausgangspunkt, um zu registrieren, was der Nutzer von ihm erwartet, und um die anschliessende Sprachverarbeitung zu steuern.

Im Unterschied zu Interaktionen zwischen anwesenden Personen fokussiert die Interaktion zwischen Nutzer und Sprachmodell auf die Verarbeitung explizit geäusserter Mitteilungen. Nonverbale und paraverbale Aspekte der Kommunikation werden ausgeblendet.

Tokenizer

Die Funktion des Tokenizers besteht darin, eine Eingabesequenz von Wörtern in einzelne Tokens zu dekomponieren. Ein Token kann ein Wort, ein Wortteil oder ein Zeichen sein.

In Anlehnung an die Unterscheidung von Medium und Form könnte man sagen: Der Tokenizer dekomponiert einen Text, eine Einheit von strikt gekoppelten Elementen im Medium der Schrift, in lose gekoppelte Elemente. Dabei müssen die vom Tokenizer produzierten Tokens nicht kongruent zu den lose gekoppelten Elementen sein, die der Verfasser des Textes ursprünglich selegiert hat. Dies liegt daran, dass der Tokenizer spezifische Algorithmen und Regeln für die Zerlegung des Textes in Tokens verwendet.

Die Art und Weise, wie die Sequenzierung bzw. Entkopplung durchgeführt wird, beeinflusst die Leistungsfähigkeit eines Sprachmodells. Wird ein Text in zu kleine Elemente zerlegt, dann gehen semantische und kontextuelle Informationen verloren. Sind die Elemente zu gross, ist die Flexibilität bei der Weiterverarbeitung von Sprache eingeschränkt.

Die Läng einer Eingabesequenz ist technisch bedingt limitiert, zum Beispiel 512 Tokens in der ursprünglichen Transformer-Architektur. Jedes Token in der Eingabesequenz erhält einen eindeutigen Index (T1, T2 … Tn). Dieser Index wird verwendet, um das entsprechende Word Embedding zu finden und um die Position eines Tokens in der Sequenz zu bestimmen.

Letztendlich dient der Tokenizer dazu, einen schriftlichen Text in eine Form zu bringen, dir für ein Sprachmodell verrechenbar ist. Er kommt beim Training eines Sprachmodells als auch in der Interaktion mit den Nutzern zum Einsatz.

Word Embeddings

Die Funktion von Word Embeddings besteht darin, Wörter in eine Reihe von Zahlen (Vektoren) umzuwandeln. Dies ist notwendig, da Sprachmodelle nur mit Zahlen und nicht mit Wörtern operieren können.

Die Vektorrepräsentationen von Wörtern bilden eine hochdimensionalen semantischen Raum. Word Embeddings können Hunderte von Dimensionen aufweisen. Jede Dimension steht für eine Eigenschaft des Wortes. Die genaue Position des Wortes in diesem semantischen Raum gibt Auskunft über seine Bedeutung und Verwendung. Mit dieser hochdimensionalen Darstellung können Word Embeddings subtile Unterschiede und Beziehungen zwischen Wörtern erfassen. Dies ermöglicht es Sprachmodellen, basierend auf den vorherigen Wörtern in einem Text die Wahrscheinlichkeit des Vorkommens des nächsten Wortes vorherzusagen.

Zur Erstellung von Word Embeddings wird ein neuronales Netz mit einem grossen Korpus von Textdateien trainiert. Während des Trainings lernt das Netzwerk nicht nur Wahrscheinlichkeiten, sondern verfeinert gleichzeitig auch die Vektorrepräsentationen der verwendeten Wörter.

Mit Wittgenstein können wir sagen, dass sich auch bei Sprachmodellen die Bedeutung der Wörter bzw. deren Zusammenhänge aus ihrem Gebrauch ergeben. So liegen im semantischen Raum der Sprachmodelle Wörter mit ähnlicher Bedeutung näher und Wörter mit unterschiedlicher Bedeutung weiter voneinander entfernt.

Einmal erstellt und trainiert, werden Word Embeddings in einer Art von Wörterbuch («vocabulary dataset») gespeichert. Bei der Verarbeitung einer Eingabesequenz schlägt das Sprachmodell jedes Input-Token im Wörterbuch nach und erhält jeweils einen eindeutigen, ganzzahligen Index. Dieser Index wird wiederum verwendet, um das dem Input-Token entsprechende Word Embedding zu finden. Das Word Embedding bzw. die Vektorrepräsentation eines Wortes bildet die tatsächliche Eingabe für das Sprachmodell.

Netzwerkarchitektur

Die Funktion der Architektur eines Künstlichen Neuronalen Netzes (KNN) besteht darin, eine Sequenz von Input-Tokens in eine Sequenz von Output-Tokens zu transformieren.

Bis zur Einführung des Transformers war das Recurrent Neural Network (RNN) eine weit verbreitete Architektur. Es verarbeitet sequenzielle Daten wie Schrift. Seine Funktion besteht darin, auf eine Sequenz von Input-Tokens eine konsistente Sequenz von Output-Tokens zu berechnen.

Während herkömmliche Architekturen wie das Feedforward Neural Network (FFNN) Input-Tokens nur in eine Richtung, von der Eingabeschicht zur Ausgabeschicht, prozessieren, machen RNNs die Ausgabe eines Output-Tokens von der Sequenz der zuvor eingegebenen Input-Tokens abhängig. RNNs sind also in der Lage, sich bis zu einem gewissen Grad an Kontextinformationen aus den vorhergehenden Input-Tokens zu erinnern und diese Informationen zur Generierung des nachfolgenden Output-Tokens zu verwenden.

Da das RNN die Kontextinformationen früherer Input-Tokens verwendet, um aktuelle Input-Tokens und Output-Tokens zu beeinflussen, verfügt es über eine Art von Kurzzeitgedächtnis. Es ist jedoch nicht in der Lage, Kontextinformationen über längere Sequenzen von Tokens hinweg zu speichern. Deshalb wurde das sogenannte Long Short-Term Memory (LSTM) entwickelt. Dabei handelt es sich um eine spezielle Art von RNNs, die sich Abhängigkeiten von Tokens in längeren Eingabesequenzen merken können und damit das Problem des Kurzzeitgedächtnisses überwinden.

Eine weitere Möglichkeit, Kontextinformationen zu berücksichtigen, bietet die sogenannte Transformer-Architektur. Sie hat die Verarbeitung natürlicher Sprache einen grossen Schritt vorangebracht.

Die Transformer-Architektur wurde erstmals im viel zitierten Aufsatz «Attention Is All You Need» von Vaswani et al. im Jahr 2017 vorgestellt. Ausgangspunkt des Aufsatzes sind die grundlegenden Einschränkungen, die bei der sequenziellen Verarbeitung von Daten durch RNNs bzw. LSTMs auftreten.

Der sogenannte Selbstaufmerksamkeits-Mechanismus des Transformers hebt die Einschränkungen der sequenziellen Verarbeitung auf. Der Mechanismus erlaubt es, Beziehungen zwischen Wörtern bzw. Tokens gleichzeitig zu erkennen und parallel zu verarbeiten, ohne auf eine sequenzielle Verarbeitung angewiesen zu sein. Im Vergleich zu RNNs und LSTMs führt dies zu einer erheblichen Effizienzsteigerung bei der Verarbeitung natürlicher Sprache geführt. Die weiteren Ausführungen beziehen sich auf die Transformer-Architektur.

Input Embedding

Die Funktion des Input Embeddings besteht darin, jedem Input-Token ein Word Embedding zuzuordnen.

In der Transformer-Architektur besteht der erste Schritt darin, jedem Input-Token aus einer Eingabesequenz ein Word-Embedding zugeordnet. Wie oben erläutert, werden die Word Embeddings während der Trainingsphase erstellt und können nun in der Nutzungsphase wie aus einem Wörterbuch abgerufen werden.

Positional Encoding

Die Funktion des Positional Encoding besteht darin, jedem Input-Token seine Position innerhalb einer Eingabesequenz zuzuordnen.

Im Unterschied zum Input Embedding geht es beim Positional Encoding nicht um die Bedeutung der Wörter, sondern um ihre Reihenfolge innerhalb einer Eingabesequenz. Die Kodierung der Position von Tokens ist für die Transformer-Architektur wichtig, da sie sich im Unterschied zu RNNs und LSTMs die Reihenfolge der Input-Tokens nicht merken kann.

In diesem zweiten Schritt werden Positional Encodings als zusätzlicher Vektor zu jedem Input-Token hinzugefügt. Anschliessend werden die Input-Tokens mit den ihnen zugeordneten Input Embeddings (semantische Bedeutungen) und kodierten Positionen (Positionen in einem Satz) an den Encoder übergeben.

Encoder

Die Funktion des Encoders besteht darin, eine Eingabesequenz, die aus einer Reihe von Input-Tokens besteht, in einen Kontextvektor umzuwandeln. Der Kontextvektor repräsentiert die gesamte Eingabesequenz und kodiert ihre wesentlichen Merkmale.

Der Encoder der ursprünglichen Transformer-Architektur umfasst sechs identischen Schichten oder Blocks («transformer blocks»), die die Input-Tokens parallel verarbeiten. Jede Schicht enthält zwei Teilschichten. Die erste Teilschicht besteht aus einem Selbstaufmerksamkeits-Mechanismus («self-attention») und die zweite aus einem Feedforward Neural Network (FFNN).

Zum einen erlaubt es der Selbstaufmerksamkeits-Mechanismus, komplexe Beziehungen zwischen den Input-Tokens in einer längeren Eingabesequenz zu erkennen. Dadurch unterschiedet sich der Transformer wesentlich von RNNs und LSTMs. Zum anderen kann der Mechanismus den Kontext der Eingabesequenz verstehen und ambigue Bedeutungen von Input-Tokens mit auflösen.

Kommt beispielsweise in einer Eingabesequenz das Input-Token «Bank» vor, so muss der Encoder in der Lage sein, aus dem Gesamtkontext zu bestimmen, ob es sich bei der Bedeutung dieses Tokens um ein «Geldinstitut» oder um eine «Sitzgelegenheit» handelt. Dazu wird jedem Input-Token eine «Aufmerksamkeit» bzw. eine Gewichtung (W) zugewiesen. Steht das Input-Token «Bank» in der Nähe von Input-Tokens wie «Geld», «Konto» und «Zinsen», wird es als «Geldinstitut» interpretiert. Befindet sich das Input-Token «Bank» jedoch in der Nähe von Input-Tokens wie «Park», «Baum» und «Sitz», wird es als «Sitzgelegenheit» interpretiert.

^ ^ ^